Epoka cyfrowa zapoczątkowała erę bezprecedensowego tworzenia i udostępniania treści wizualnych. Jednak rozprzestrzenianie się deepfake’ów i obrazów generowanych przez sztuczną inteligencję rzuciło długi cień na autentyczność tego, co widzimy w Internecie.

Dla twórców i agencji poruszanie się w tym środowisku jest kluczowe. Zrozumienie ograniczeń obecnych systemów weryfikacji obrazu jest niezbędne do skutecznego prezentowania treści wizualnych. Opowiadając się za przejściem w stronę weryfikacji, a nie wykrywania, możemy przyczynić się do powstania ekosystemu medialnego, w którym dokładność i zaufanie są najważniejsze.

Nadszedł czas, aby wyjść poza zwykłe oznaczanie fałszerstw i skierować się ku przyszłości, w której będziemy mogli z pewnością zweryfikować prawdę.

Fałszywe newsy, prawdziwe obrazy, czyli kryzys weryfikacji wizualnej

W erze cyfrowej, gdzie obrazy są tworzone, udostępniane i manipulowane w niespotykanym wcześniej tempie, kwestia autentyczności wizualnych treści stała się palącym problemem. Deepfakes, czyli hiperrealistyczne, fałszywe obrazy i filmy, z łatwością mogą wprowadzić odbiorców w błąd.

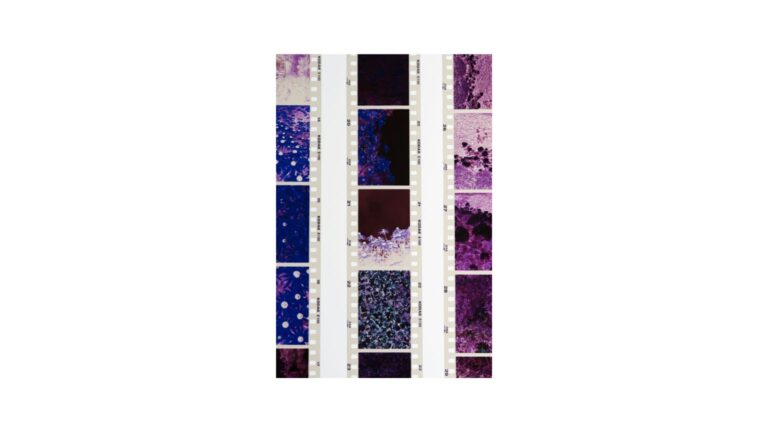

Platformy takie jak Meta, oferując inicjatywy takie jak tag „Made with AI”, próbowały rozwiązać problem fałszywych obrazów. Rzeczywistość jest jednak znacznie bardziej złożona.

Niestety, okazuje się, że te systemy są dalekie od doskonałości. Realne zdjęcia są często błędnie oznaczane jako fałszywe, co podważa zaufanie użytkowników do tych narzędzi.

Przykład? Zdjęcie związane z głośnym zamachem zostało błędnie oznaczone jako zmanipulowane z powodu niewielkich edycji. To pokazuje, jak łatwo można nadużyć systemy weryfikacji obrazów, a co za tym idzie, manipulować opinią publiczną.

Dlaczego to takie ważne?

- Erozja zaufania: Gdy systemy, które mają chronić nas przed dezinformacją, zawodzą, traci się wiarę w ich skuteczność.

- Manipulacja informacją: Fałszywe informacje mogą mieć poważne konsekwencje społeczne i polityczne.

- Utrudnienie debaty publicznej: Gdy trudno jest odróżnić prawdę od fikcji, trudno prowadzić rzeczową debatę.

Co dalej?

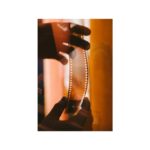

Zamiast skupiać się wyłącznie na wykrywaniu fałszywych obrazów, powinniśmy zwrócić większą uwagę na weryfikację autentyczności tych prawdziwych. Inicjatywy takie jak Content Authenticity Initiative (CAI) proponują stworzenie cyfrowego podpisu dla każdego obrazu, co umożliwi śledzenie jego historii i wykrywanie wszelkich zmian.

Jakie są wyzwania?

- Szerokie wdrożenie: Aby systemy weryfikacji działały skutecznie, muszą być powszechnie stosowane.

- Koszty: Wdrożenie takich systemów wymaga znacznych inwestycji.

- Złożoność techniczna: Tworzenie niepodrabialnych cyfrowych podpisów to zadanie wymagające zaawansowanej wiedzy technicznej.

Co to oznacza dla twórców i agencji?

- Rozumienie ograniczeń: Ważne jest, aby zdawać sobie sprawę z ograniczeń obecnych systemów weryfikacji obrazów.

- Promowanie autentyczności: Twórcy powinni dążyć do tworzenia treści, które są nie tylko oryginalne, ale także wiarygodne.

- Współpraca z platformami: Należy współpracować z platformami społecznościowymi, aby wspólnie wypracować skuteczne rozwiązania.

Problem fałszywych obrazów jest złożony i wymaga kompleksowego podejścia. Choć wykrywanie fałszywych treści jest ważne, równie istotna jest weryfikacja autentyczności tych prawdziwych. Tylko poprzez wspólne wysiłki możemy stworzyć cyfrową przestrzeń, w której informacje są wiarygodne, a dezinformacja nie ma szans.

Pytania do dyskusji:

- Jakie są Twoim zdaniem największe wyzwania związane z weryfikacją autentyczności obrazów?

- Jakie narzędzia i technologie mogłyby pomóc w rozwiązaniu tego problemu?

- Jakie kroki powinni podjąć użytkownicy, twórcy i platformy społecznościowe, aby zwiększyć zaufanie do informacji wizualnych?

Chcesz dowiedzieć się więcej na ten temat? Z przyjemnością odpowiem na Twoje pytania.